Vous n'êtes pas identifié.

• Annonce ToutSurTout

Déjà 16 ans !

Si vous souhaitez participer vous aussi aux discussions sur le forum, il faut vous inscrire ou vous identifier.

Les inscriptions sont actuellement OUVERTES.

Message 1 Discussion postée le 03-10-2011 à 05:02:09

Le RAID Matériel

1) Introduction

Le RAID matériel est très utilisé dans le monde professionnel. En effet, beaucoup d'Entreprises ne peuvent se permettre de perdre des données ou bien de voire le réseau paralysé à cause d'une panne sur un disque dur. C'est pourquoi de nombreux serveurs qui reçoivent beaucoup de requêtes (serveur Web, serveur de messagerie, serveur hébergeant une base de données, ...) ou qui manipulent de gros volumes de données (serveur de fichiers) utilisent le RAID notamment matériel.

2) Quelques petits rappels

La notion de contrôleur

Très souvent dans cet article, les composants qui jouent le rôle d'interface entre le chipset sud de la carte mère et les disques durs sont nommés contrôleurs. Par exemple, on nomme contrôleur RAID IDE, un jeu de composants qui permet d'interconnecter les disques durs IDE et le chipset sud (ou southbridge) de la carte mère tout en supportant la mise en place d'un RAID matériel. En réalité, cette appellation est fausse car le contrôleur est la puce qui contrôle les actions du disque dur (déplacement des têtes, état du cache,...).

Cette puce est située sur le disque dur lui-même et non sur la carte mère. Le jeu de composants qui permet de relier le disque et la carte mère est en fait un simple adaptateur et devrait être nommé comme tel. Cependant, par abus de langage, les utilisateurs mais aussi les constructeurs !!! désignent ce jeu de composant « contrôleur ». C'est pourquoi dans la suite de cet article, quand vous verrez le mot « contrôleur RAID SCSI », il faudra comprendre adaptateur situé sur la carte mère ou sur une carte d'extension qui propose une interface SCSI et gère la technologie RAID.

RAID PATA, RAID SATA et RAID SCSI

Dans la suite de cet article, lorsque le terme RAID IDE (ou RAID PATA) est utilisé cela signifie RAID avec des disques durs compatibles avec l'interface PATA (Parallel ATA), et lorsque le terme RAID SCSI est utilisé cela signifie RAID avec des disques durs compatibles avec l'interface SCSI. De même le terme RAID SATA désigne des ensembles de disques durs utilisant la technologie RAID composés de disques durs utilisant l'interface SATA (Serial ATA).

Bande passante et débit

Les termes bandes passantes et débits sont très souvent utilisés dans cet article et en informatique de manière générale. C'est pourquoi il ne faut pas les confondre. La bande passante représente la quantité de donné maximale que l'on peut transférer en un temps donné. Le débit représente la quantité de données réelles que l'on peut transférer en un temps donné.

3) Le RAID IDE (ou RAID PATA)

Pour les stations de travail, le problème du matériel à utiliser pour faire du RAID ne se posait pas il y a quelques années. En effet, il y a 5 ans la technologie RAID n'était disponible que pour les disques durs SCSI qui par leurs prix élitistes les réservaient au monde professionnel. Cependant grâce à la société Promise technology qui a commercialisé le premier contrôleur RAID IDE nommé FastTrack, la technologie RAID a pu être adaptée pour les disques durs à la norme IDE.

L'apparition des contrôleurs RAID IDE a fortement popularisé la technologie RAID. Cette technologie est maintenant utilisée par beaucoup d'utilisateurs avancés ou « power users » qui souhaitent obtenir de un plus grand espace de stockage, de meilleures performances ou bien encore maximiser la sécurité de leurs données.

Dorénavant, un grand nombre de cartes mères « grand public » intègrent en standard un contrôleur RAID IDE. Cependant les constructeurs de cartes mère (Asus, Abit, Gigabyte, MSI, Elite ...) peuvent intégrer ce contrôleur de deux manières différentes :

Il peut être relié directement au chipset sud (ou southbridge) de la carte mère. Ce cas de figure permet un maximum de performance car le contrôleur est généralement relié au southbridge avec des bus (ou liaisons électriques) rapides (exemple : 533Mo/s).

Il peut être rajouté sur la carte mère grâce à une connexion sur le bus PCI. Cependant, le bus PCI possède une bande passante limitée (133Mo/s par canal). En outre, La plupart du temps les constructeurs de carte mère n'utilise qu'un seul canal pour des raisons de coût. Dans ce cas la bande passante réservée au contrôleur RAID est de 133Mo/s moins la bande passante que les périphériques branchés sur les ports PCI (cartes son, cartes réseau, ...) vont consommer. Cela pourra sérieusement brider les performances en mode RAID 0 par exemple.

La seconde façon de mettre en place du RAID matériel est d'utiliser une carte contrôleur dédiée. Généralement ces cartes sont au format PCI 32 bits et en de rares occasions au format PCI 64bits. Il faut être vigilant lorsque l'on met en place du RAID sur une carte d'extension notamment au format PCI 32bits. En effet, selon les cartes mères l'ensemble des ports PCI 32bits se partage un ou plusieurs canaux avec une bande passante de 133Mo/s chacun. En admettant que la carte mère ne propose qu'un seul canal et donc une bande passante de 133Mo/s pour tous les ports PCI, il faudra veiller à ne pas mettre deux cartes RAID possédant chacune 4 disques en RAID 0 par exemple car dans ce cas les performances se retrouveraient sérieusement bridées par l'interface limitée elle à 133Mo/s.

De manière générale les cartes contrôleur IDE ne possèdent pas ou très peu de mémoire cache. Elles sont quasiment toutes au format PCI 32 bits (avec une bande passante de 133 Mo/s) et implémentent le RAID 0, 1 et 0+1 (soit le niveau 10, soit le niveau 01).

Ci-contre une carte FastTrak TX4000 de la marque Promise au format PCI 32 bits. Cette carte supporte 4 canaux ATA 133 et donc jusqu'à 8 disques durs en Ultra-DMA 133. Elle gère les niveaux RAID 0,1 et 10.

Cependant, il existe quelques cartes contrôleur RAID IDE « haut de gamme ». Ces cartes au format PCI 64 bits (avec une bande passante de 266 Mo/s par canal) implémentent le niveau RAID 5 et peuvent parfois gérer jusqu'à 16 périphériques et accueillir jusqu'à 256 Mo de mémoire (comme la carte Promise SuperTrack SX6000).

Ci à gauche, une carte RocketRAID 454 de la marque HighPoint qui possède quatre canaux Ultra ATA 133 et permet donc l'installation de 8 disques durs en UDMA 133.Cette carte implémente les niveaux RAID 0, 1, 5, 10 et JBOD.

4) Le RAID SATA

Depuis la mise en place du Serial-ATA, les cartes RAID fleurissent sur le marché. En effet, cette nouvelle interface est bien plus propice à la mise en place du RAID que l'ancienne interface ATA (encore appelée IDE). D'une part grâce aux débits plus élevés (jusqu'à 1,5Gb/s soit 187,5Mo/s par canal et bientôt 320Mo/s par canal avec le SATA2) et d'autre part grâce à la gestion du branchement à chaud ou hotplug. Les constructeurs rivalisent donc d'ingéniosité pour sortir de nouvelles cartes contrôleur RAID SATA.

On peut évoquer la carte RocktetRAID 1544 de la marque HighPoint (format 64 bits). Cette carte innove car elle possède 4 canaux eSATA (external SATA) proposant chacun une bande passante de 1.5 Gb/s soit 187.5 Mo/s. L'eSATA est une technologie propriétaire mise en place par HighPoint permettant de connecter des disques durs SATA externes (par l'intermédiaire de câbles à la norme IEEE 1394). On peut donc mettre en place un RAID matériel même si le boîtier ne contient plus d'emplacements 3,5 pouces de libre. Cette carte aussi supporte les niveaux RAID 0, 1, 5, 10 et JBOD.

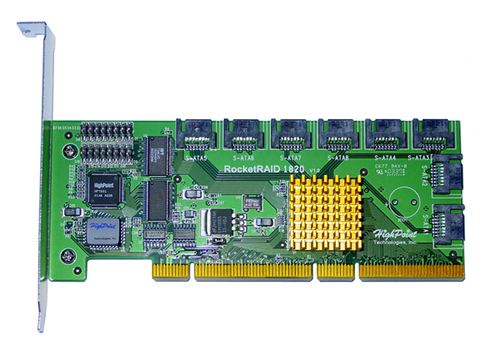

Il est noter que la marque Hightpoint commercialise aussi une version plus "huppée" de la RocketRAID 1544, nommée RocketRAID 1820. Elle propose de hautes performances et est spécialement destinée au monde de l'Entreprise. En effet, si elle ne gère pas l'eSATA, cette carte dispose de 8 canaux Serial ATA "classique" ce qui permet de connecter jusqu'à 8 périphériques. De plus elle utilise le format PCI-X 133MHz qui permet une bande passante de 1200 Mo/s. Comme sa petite soeur, elle implémente les niveaux RAID 0, 1, 5, 10 et JBOD.

5) le RAID SCSI

La technologie RAID a été pensée pour le SCSI. Ainsi, certaines cartes mères destinées aux serveurs implémentent des contrôleurs SCSI qui gèrent le RAID directement sur la carte. Mais dans la plupart des cas on doit installer une carte d'extension au format PCI-X, PCI 64 bits voire même PCI 32 bits (peu recommandé) pour mettre en place un RAID matériel.

La plupart des cartes contrôleur supportant le RAID SCSI sont très onéreuses. Ce coût élevé est dû en partie la présence de microprocesseurs performants (pour synchroniser les échanges de données entre le bus PCI et les disques branchés sur la carte et surtout pour le calcul des informations de parité) ainsi qu'à la présence d'une grande quantité de mémoire cache. Généralement la mémoire utilisée est de la mémoire SD-RAM ECC. La quantité peut varier de 32 Mo à 256 Mo de mémoire.

La présence d'autant de mémoire est justifiée. En effet, la quantité de mémoire est un facteur déterminant pour les performances surtout lorsque l'on met en place un niveau de RAID avec parité (RAID 3, 4, 5, 6, 30, 50, ...). Grâce à des cartes contrôleurs et des disques très performants, le RAID SCSI permet d'atteindre des débits impressionnants. Il n'est pas rare de dépasser les 500 Mo/s en lecture avec un niveau RAID 10 ! C'est pourquoi lorsque l'on veut mettre en place un niveau de RAID, il faut sélectionner la bonne carte.

En effet, si l'on souhaite mettre en place un niveau RAID 5 avec quatre disques tournant à 10 000 tr/min, une carte au format PCI 64 bits (c'est-à-dire avec une bande passante de 266 Mo/s) suffira.

Par contre, si l'on souhaite mettre en place un niveau RAID 10 avec seize disques tournant à 15 000 tours/min, une carte au format PCI-X (le format PCI-X permet une bande passante de 1.06 Go/s) possédant beaucoup de mémoire est fortement recommandée.

Dans le cas où l'on doit mettre en place un ensemble RAID performant, il faut essayer dans la mesure du possible d'harmoniser les composants entre eux. En effet, si l'on branche beaucoup de disque dur SCSI Ultra Wide 320 sur une carte possédant un seul canal limité à 160 Mo/s, il y a de fortes chances pour que le canal sature.

6) RAID IDE, SATA, ou SCSI : Que choisir ?

La foudroyante propagation de la technologie RAID IDE ces dernières années est due au prix des disques durs utilisant cette interface. En effet, ils sont bien moins onéreux que leurs homologues SCSI à capacité égale.

Ils sont très intéressants pour les particuliers. Mais ils sont aussi une opportunité pour les petites entreprises ayant un budget limité et qui souhaitent sécuriser leurs données à moindre coût.

L'interface PATA qui a atteint ses limites (largeur des nappes, débits limités à cause de la trop grande sensibilité des transfert parralèles aux interférences électromagnétiques, pas de hotplug, ...) est en passe d'être remplacé par l'interface Serial ATA. Le SATA se positionne dans la même gamme de prix que le PATA. C'est pourquoi nous allons faire l'impasse sur le PATA et essayer de savoir quelle interface est la plus intéressante. Alors : SCSI ou SATA?

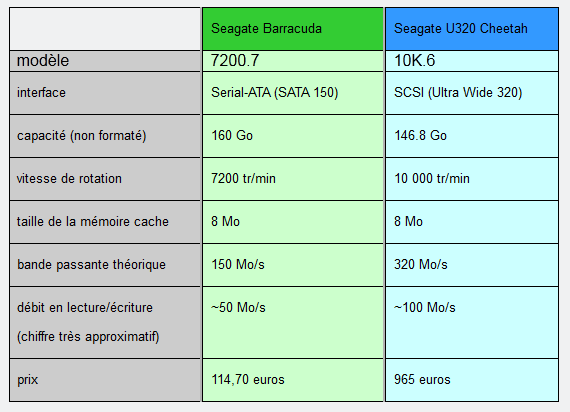

Voici un petit tableau qui compare les caractéristiques de deux disques durs de la marque Seagate : le premier utilise l'interface Serial-ATA et le second utilise l'interface SCSI. Les informations contenues dans le tableau suivant ont été relevées sur le comparateur de prix : www.prixdunet.com le 25/01/2004.

Il est indéniable que pour une même capacité, le rapport performance/prix du disque Serial-ATA est supérieur à celui du disque SCSI. En effet, pour le prix du disque SCSI, on peut acheter 7 disques utilisant l'interface Serial-ATA. Le disque SCSI ne peut justifier cette différence de prix malgré ses meilleures performances (de part leurs vitesses de rotation plus élevées, les disques SCSI offrent de meilleurs débits et surtout des temps d'accès moyens réels plus faibles que les disques SATA) et son temps moyen entre pannes (ou MTBF = Mean Time Between Failure) supérieur.

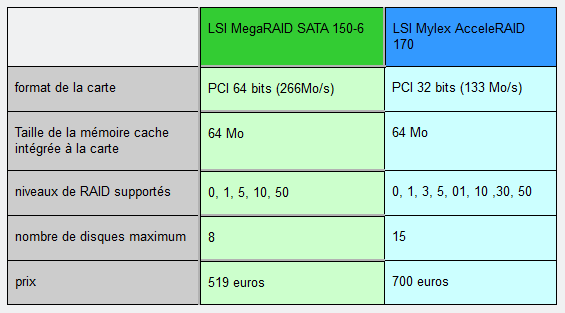

Voici maintenant un petit comparatif entre deux cartes contrôleurs de la marque LSI. L'une des cartes supporte l'interface SCSI et l'autre l'interface Serial-ATA. La carte à la norme SCSI permet d'accueillir plus de disques durs et gère plus de modes RAID différents, cependant elle est plus chère et les performances seront fortement bridée par le format PCI 32 bits utilisé ici.

On peut donc conclure que les prix des cartes contrôleurs « haut de gamme » sont sensiblement les mêmes que ça soit pour le Serial ATA ou bien encore le SCSI. L'avantage des disques durs Serial ATA reste donc leur prix peu élevé par rapport aux disques SCSI.

Pour conclure, l'interface Serial-ATA est donc une excellente alternative à l'interface SCSI sauf bien entendu sur les gros serveurs de fichiers pour lesquels les performances passent avant le prix.

7) Les dispositifs de stockages réseau NAS

Il existe autre solution de stockage fréquemment utilisé par les Entreprises : les périphériques de stockage en réseau. Il existe deux type de technologies de stockage en réseau : le NAS (pour Network Attached Storage) et le SAN (pour Storage Area Network).

Le NAS (Network Attached Storage)

Les périphériques de stockage NAS utilisent le réseau Ethernet de l'entreprise. Cela signifie qu'un périphérique de stockage NAS possèdera une ou plusieurs interfaces réseau et sera reconnu sur le réseau grâce à son adresse IP.

Dans l'exemple ci-dessous, un périphérique de stockage NAS est configuré avec l'adresse IP 172.16.0.10. Tous les ordinateurs du réseau local (LAN) peuvent le joindre et peuvent accéder aux données qu'il contient (si les autorisations d'accès le permettent).

Les NAS se présentent la plupart du temps sous la forme de boîtiers externes possédant leurs propre source d'alimentation. Ces boîtiers sont soit autonomes, soit intégrables dans des backbones (généralement dans des racks 1U, 2U ou 3U d'une taille de 19'').

Ils contiennent généralement plusieurs disques durs le plus souvent avec une interface SCSI. Les NAS permettent de mettre en place le RAID très facilement. On peut ainsi obtenir des unités de stockages très fiables et faciles à mettre en place. En effet, les serveurs de fichiers qui utilisent « une machine complète » ont beaucoup plus de chances de tomber en panne que les NAS (surchauffe du processeur, barrette de mémoire grillée ou tout simplement plantage du système d'exploitation).

Le plus souvent les NAS sont reliés au réseau via une prise RJ45 gigabit. On trouve parfois des NAS d'entrée de gamme utilisant une prise RJ45 en 10/100. La configuration d'un NAS se fait généralement grâce à une interface Web (c'est-à-dire qu'ils contiennent un serveur HTTP).

Les NAS permettent donc de partager des données sur le réseau tout en proposant une grande fiabilité (ils sont à l'abris des pannes d'ordre logiciel), des performances de premier ordre (grâce au RAID), une intégration et une maintenance facilité (le plus souvent au format 19'', monitoring en façade, système de racks, disques échangeables à chaud en cas de panne,...). En fait, le seul inconvénient des NAS est leur prix élevé qui les met hors de la portée des petites entreprises.

Le NDAS (Network Direct Attached Storage)

Attention !!! Il ne faut pas confondre NAS (Network Attached Storage) et NDAS (Network Direct Attached Storage). En effet, les NDAS se présentent aussi sous la forme de boîtiers contenant des disques durs.

Contrairement aux NAS, les périphériques NDAS ne sont pas directement reliés au réseau mais doivent passer par un ordinateur pour communiquer avec le réseau. Il ne sont donc pas totalement autonomes (la plupart du temps, il faut installer un pilote pour que les ordinateurs du réseau puissent communiquer avec un périphérique NDAS). De plus les NDAS contiennent généralement un seul disque et n'implémentent donc pas la technologie RAID. Cela signifie que les NDAS ne gèrent pas la tolérance de pannes.

Ci-contre le Netdisk de la marque Ximeta est un disque dur NDAS. Il contient un disque dur de 80, 120 ou 160Go (selon les versions) tournant à 7200tr/min et possédant 2Mo de cache. Il peut se raccorder à une machine ou au réseau grâce à un port USB 2.0 ou bien grâce à une prise RJ45. De plus on peut le paramétrer avec une interface web.

Pour se raccorder à la machines, les NDAS utilisent le plus souvent l'interface IEEE1394 (firewire) qui autorise une bande passante de 400Mb/s ou bien encore l'interface USB 2.0 qui autorise une bande passante de 480Mb/s (parfois les NDAS utilisent l'USB 1.1 qui offre une bande passante de 12Mb/s...). Certains NDAS, possèdent aussi des prises RJ45 et proposent une interface web.

8) Les dispositifs de stockage dans un réseau SAN

Contrairement au NAS, le SAN n'utilise pas un réseau de type Ethernet mais un réseau de type Fibre Channel (FC). Les médias utilisés pour un réseau de type Fibre Channel sont soit des câbles en cuivre, soit des fibres optique (monomode ou multimode) qui supportent une bande passante de 2Gb/s. On préfère généralement l'utilisation de fibres optique qui permettent d'utiliser des câbles allant jusqu'à 10 Km (fibre optique monomode) contre 30 m pour les câbles en cuivre.

Le protocole utilisé dans les réseaux SAN étant différent du protocole Ethernet, il nécessite un matériel différent. Ainsi on trouve des cartes réseaux, des disques durs, des concentrateurs et des commutateurs utilisant l'interface Fibre Channel. De plus il faut installer des composants logiciels sur les ordinateurs branchés sur le réseau SAN afin d'administrer la sécurité et les autorisations d'accès aux données.

Les Adaptateurs de bus Fibre Channel (HBA)

Les cartes réseaux compatibles avec le protocole Fibre Channel sont généralement appelées Host Bus Adaptateur (HBA) ou adaptateur de bus Fibre Channel pour utiliser le terme francisé. Les adaptateurs de bus Fibre Channel sont généralement proposés sous la forme de cartes d'extension au format PCI-X (bande passante de 1.06 Go/s) ou bien PCI 64bits (bande passante de 266Mo/s). Mais on commence à trouver sur le marché des adaptateurs au récent format PCI Express 4X qui fournissent une bande passante de (266 Mo/s) * 4 = 1064 Mo/s.

Ci-dessus, un adaptateur de bus Fibre Channel de marque Qlogic. Il utilise le format PCI-X qui propose une bande passante de 1.06 Go/s ce qui lui permet de proposer 4 ports Fibre Channel d'une bande passante de 2 Gb/s (soit 250Mo/s) chacun.

La marque Qlogic vient aussi de commercialiser un adaptateur utilisant le format PCI Express dans sa version 4X. Cette carte communique donc avec la carte mère avec une bande passante de 1064 Mo/s. Elle offre 2 ports Fibre Channel proposant chacun une bande passante de 2Go/s chacun.

Les disques durs Fibre Channel

Il existe aussi des disques durs possédants une interface Fibre Channel. On peut les brancher de deux différentes façons :

- directement sur un commutateur Fibre Channel

- dans une baie de disques durs qui, elle, sera raccordée à un commutateur

De manière générale, les constructeurs de disques durs créent des disques utilisant l'interface Fibre Channel à partir de leurs gammes SCSI.

Ainsi, on peut trouver des disques durs utilisant l'interface Fibre Channel dans la gamme Ultrastar d'Hitachi (anciennement IBNM) ou bien dans la gamme Cheetah de Seagate.

Les baies de stockage SAN

Lorsque l'on souhaite mettre en place un système de stockage performant, il faut utiliser une baie de stockage intégrée dans un réseau SAN. Les baies de stockages utilisée dans les réseaux SAN sont généralement au format 19'' ce qui permet de les « racker » dans des backbones. On peut parfois rassembler plusieurs baies de stockage pour former un module de stockage et ainsi atteindre de plus grandes performances.

Ci-dessus un rack 3U au format 19'' de la marque Adaptec. Ce modèle (le SANbloc 2Gb RAID) peut accueillir jusqu'à 14 disques SCSI de 3.5''. Il possède deux contrôleurs RAID (pour la tolérance de panne) et implémente les modes 0, 1, 3, 5, 10, 30, 50. Il est relié au réseau grâce à deux prises optiques avec une bande passante de 1 Gb/s chacune.

Voici une autre baie de stockage SAN, de marque Dell | EMC (modèle CX700). Cette baie peut contenir jusqu'à 15 disques durs avec une interface Fibre Channel ou ATA pour une capacité de stockage totale de 35To en FC et 74,16To en ATA. Elle gère les niveaux RAID 0, 1, 3, 5 et 10. Cette baie incorpore aussi 8 Go de mémoire cache.

Le CX 700 propose 8 ports FC en façade (cela signifie qu'on peut brancher jusqu'à 8 ordinateurs directement sur la baie de disque) et des ports Fibre Channel situés à l'arrière afin de relier le CX 700 à d'autres baies de stockages CX 700.

On peut ainsi créer un gros module de stockage utilisant la technologie RAID en raccordant 16 baies de stockage CX 700 entres-elles. Cela permet donc de créer un module de stockage composé d'un maximum de (15 disques/baie) * (16 baies interconnectées) = 240 disques durs accessible par un maximum de (8 ordinateurs/baie) * (16 baies interconnectées) = 128 ordinateurs.

Selon Dell et EMC, les performances d'une seule baie CX 700 peuvent autorisent un débit constant supérieur à 1300 Mo/s. Les performances d'un module de stockage composé de plusieurs CX 700 peuvent donc procurer des performances de très haut niveau.

MAJ (13/02/2006) : Les caractéristiques du CX 700 ont été revues à la hausse depuis la publication originale de cet article. Ainsi les modèles actuels peuvent toujours embarquer jusqu'à 240 disques (en combinant plusieurs bais entre-elles) et la capacité maximale est passée à 120To (grâce au support des disques durs PATA de 500Go). La bande passante frontal de la nouvelle édition est de 1530 Mo/s (environ 200 000 entrées/sorties par seconde). De plus, il est possible de raccorder jusqu'à 256 serveurs à une même baie CX 700 en utilisant le commutateur approprié !

Les commutateurs SAN

Pour relier tous les ordinateurs, les disques durs et les baies de disques durs utilisant l'interface Fibre Channel, il faut utiliser un commutateur (ou switch) supportant le Fibre Channel. Il existe des commutateurs proposant des ports Fibre Channel (2Gb/s) et gigabit Ethernet (1Gb/s) afin de permettre l'interopérabilité (c'est-à-dire la communication) entre réseau SAN et réseau Ethernet.

Ci-dessous, un commutateur de marque Gadzoox qui propose 16 prises Fibre Channel (2Gb/s par port) et une prise RJ45 (1Gb/s).

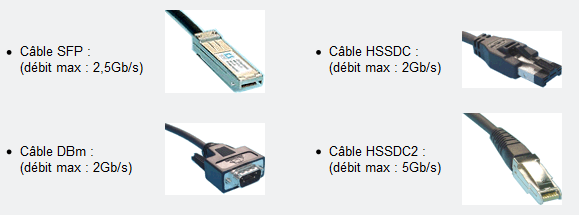

Les médias utilisés

Selon la configuration matérielle utilisée, différents types de câbles sont utilisés :

Exemples de SAN

Voici comment un exemple d'intégration d'un réseau SAN au sain d'un réseau d'entreprise utilisant le protocole Ethernet. On dispose de trois serveurs. L'un de ces serveurs travaille sur une base de données stockée sur un module de stockage lui aussi dans le réseau SAN. Un serveur HTTP et un serveur Exchange ont aussi accès à des données stockées sur le module de stockage. Le module de stockage est composé de trois baies de stockage interconnectées. Enfin, un commutateur assure les connexions entre les différents composants du réseau SAN et permet aussi aux réseaux SAN et Ethernet de communiquer entre eux.

Une autre utilisation typique d'un réseau SAN est la mise en place d'un cluster. En effet, un cluster est un ensemble de machine vu par le réseau de l'entreprise comme étant une seule et même machine (vu du réseau un cluster possède un seul nom et une seule adresse IP).

Par exemple, on peut créer un réseau SAN contenant 5 serveurs exécutant IIS (Internet Information Service) pointant tous vers le même support de stockage (une baie de stockage par exemple). Une fois le service de clustering MSCS installé et le Network Load Balancing (NLB) paramétré, on dispose d'un cluster qui répartit la charge réseau (les requêtes HTTP vers le cluster sont distribuées de façon équitables entre les cinq machines exécutant IIS) et qui gère la tolérance de panne (on peut perdre jusqu'à 4 machines sur 5 dans ce type de configuration).

Pour plus d'informations concernant la mise en place du service de clustering et du load balancing, je vous renvoie aux articles suivants :

- Le clustering MSCS

- Le Network Load Balancing

Si vous souhaitez voir un exemple pratique de l'implémentation d'un réseau SAN, allez visiter le site du Centre Interuniversitaire de Calcul de Toulouse. En effet, le CICT a mis en ligne la configuration du réseau SAN qu'il a mis en place en 2001. Pour les curieux, c'est ici.

Conclusion

Les SAN proposent de bien meilleures performances que les solutions de stockage NAS. Cependant, les SAN nécessitent une infrastructure réseau complètement différente du réseau Ethernet classique utilisé dans le reste de l'entreprise. Cela apporte des inconvénients (il faut un gros investissement matériel pour mettre en place un SAN) et des avantages (meilleure fiabilité, meilleures performances, le réseaux SAN permet de décharger le réseau Ethernet). L'utilisation d'un SAN dépend donc des besoins de l'entreprise.

9) Le hotspare

Certaine cartes RAID et/ou périphériques NAS permettent de brancher un ou plusieurs disques de rechange (spare disks). Ces disques ne sont pas utilisés sauf en cas de panne de l'un des disques. Voici un petit exemple :

Dans l'exemple précédent, on a mis en place un RAID 1 avec deux disques et on a aussi rajouté un disque de spare (bien entendu il faut un équipement qui supporte le hotspare). Si l'un des disques de l'ensemble RAID un vient à tomber en panne, il sera immédiatement remplacé par le disque de spare. Cela permet d'augmenter la tolérance de panne de l'ensemble RAID car si on utilise un disque de spare, on peut se permettre de perdre un disque supplémentaire sans perte de données. Cela est bien entendu coûteux en terme d'équipement sur des petits ensemble RAID. Par contre sur de gros ensembles (5 disques et plus) cela peut devenir très intéressant.

Par exemple, si l'on a une carte RAID adaptée on peut créer un RAID 50 avec seize disques durs (4 ensembles RAID 5 de quatre disques durs chacun montés en RAID 0) et rajouter un 17è disque de secours. Si l'un des disques de l'ensemble RAID 5 tombe en panne alors le disque de rechange prend instantanément le relais ce qui permet de conserver la tolérance de panne. L'administrateur peut ensuite changer tranquillement le disque défectueux sachant que le système reste sécurisé.

Attention, il ne faut pas confondre le hotspare avec le hotplug. Le hotplug (encore appelé hotswap) est une technologie qui permet de brancher à chaud diverses équipement. Par exemple, l'interface USB supporte le hotplug (on peut brancher/débrancher des périphériques USB même lorsque le système est en fonctionnement). Au niveau des périphériques de stockages, seuls deux interfaces supportent le branchement à chaud : l'interface SCSI et l'interface SATA.

Pour conclure, le hotspare permet d'augmenter la sécurité d'un ensemble RAID. Il est généralement supporté par les cartes RAID "haut de gamme" et par les NAS. Il est surtout utilisé sur de gros ensembles de disques.

10) Conclusion

Le RAID matériel est une solution très intéressante pour améliorer la sécurité et/ou les performances des données stockées sur une machine ou sur le réseau. La solution la plus efficace mais aussi la plus chère reste l'utilisation de périphériques dédiés (NAS). Mais pour des raisons de coût, les entreprises mettent souvent en place le RAID via des cartes d'extensions. Il faut alors faire un choix entre RAID SCSI (plus performant, plus fiable et plus cher) et RAID SATA. Il est préférable de faire une impasse sur le RAID PATA car c'est une technologie vieillissante. On peut ausi améliorer la sécurité des gros ensemble RAID grâce à l'utilisation d'un ou plusieurs disques de spare. Enfin, on peut aussi améliorer la sécurité ou les performances en créant une combinaison entre plusieurs modes de RAID (exemple de combinaison : RAID 10) en utilisant du RAID matériel et du RAID logiciel. L'avantage du RAID logiciel étant de permettre aux Entreprises et éventuellement aux particuliers qui ont un budget limité de mettre en place la technologie RAID.

Loic DL un jour, Loic DL toujours ...