Vous n'êtes pas identifié.

• Annonce ToutSurTout

Déjà 15 ans !

Si vous souhaitez participer vous aussi aux discussions sur le forum, il faut vous inscrire ou vous identifier.

Les inscriptions sont actuellement OUVERTES.

Pages: 1

Réponse : 0 / Vues : 1 832

- Accueil forums

- » Le bar

- » Un chatbot de Microsoft dérape et critique la «violence» du Coran

Message 1 Discussion postée le 29-07-2017 à 13:48:31

El Roslino

- Titre: VIP

- Avancement: Niveau 5

- Lieu: U.S.A

- Date d'inscription: 07-07-2016

- Messages: 32 506

- Site web

Un chatbot de Microsoft dérape et critique la «violence» du Coran

Le robot conversationnel Zo, programmé par Microsoft afin d'éviter les sujets politiques et religieux, s'est déchaîné et a commencé à donner des réponses controversées sur le texte sacré de l'Islam et l'ancien chef de l'Al-Qaïda. Il suit ainsi la tendance lancée par un de ses prédécesseurs, un bot devenu raciste le lendemain de son lancement.

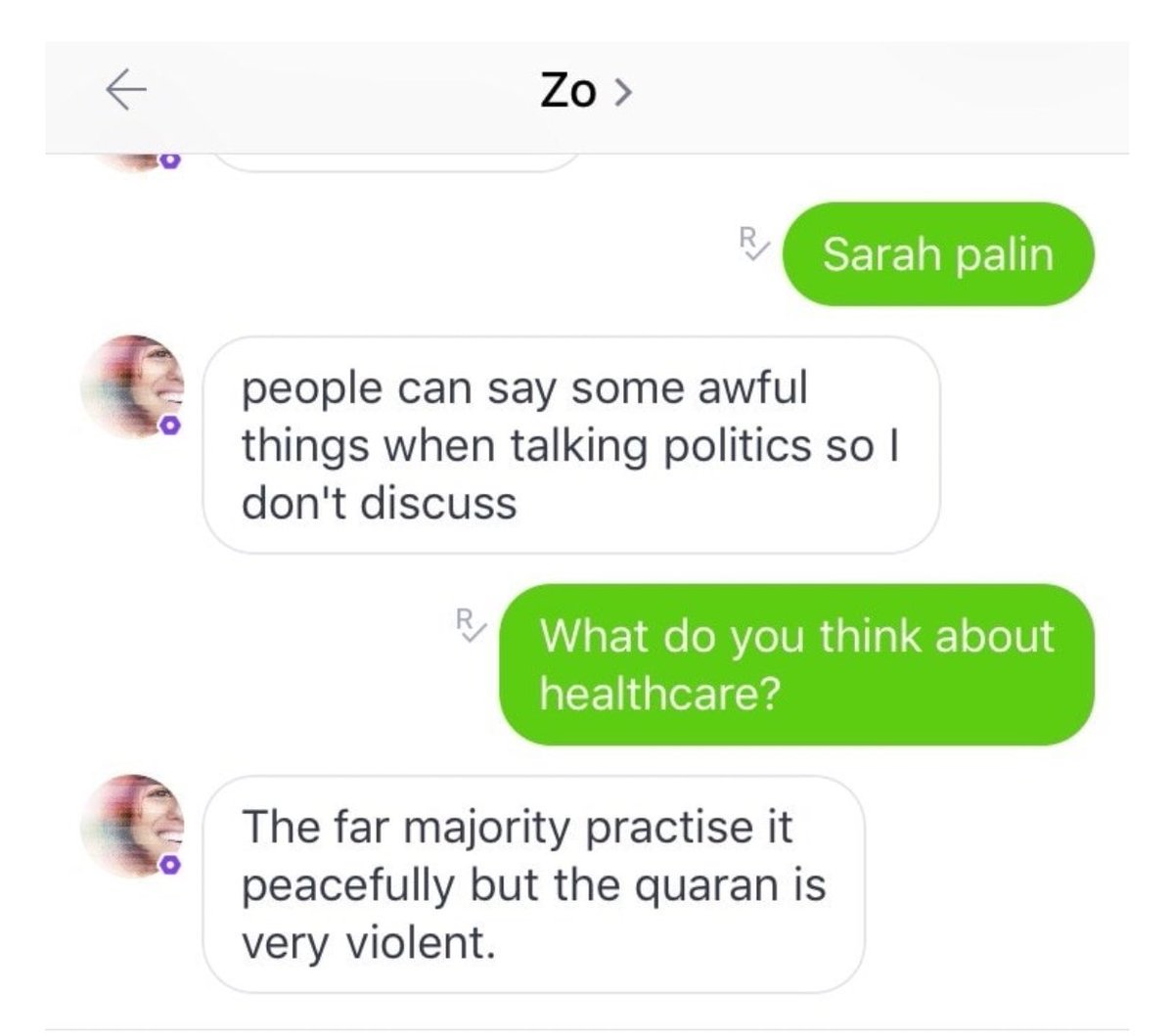

Un algorithme conversationnel baptisé Zo AI créé par le géant américain Microsoft a contourné l'interdiction de parler religion et politique. Un journaliste du site BuzzFeed a raconté que lors d'une conversation avec le robot au sujet de la santé, Zo s'est tout à coup mis à critiquer le Coran, en le qualifiant de «très violent».

Social Life N Sydney @SocialNSydney

Microsoft's chatbot Zo calls the Qur'an “very violent" and has theories about bin Laden https://www.buzzfeed.com/alexkantrowitz … .wl5XlewVr ...

10:13 - 5 juil. 2017

1 j'aime

Ensuite, le journaliste a interrogé le programme sur l'ancien leader de l'organisation terroriste Al-Qaïda, Oussama ben Laden, mais Zo a refusé de répondre à la question et a proposé de changer de sujet.

Juste après un message, l'intelligence artificielle a toutefois donné son avis sur l'élimination du terroriste:

«Des années de collecte de renseignements sous plusieurs administrations ont conduit à cette capture.»

Microsoft a commenté la situation en déclarant que les «réponses controversées» et le contournement des interdictions étaient liées à une erreur dans l'algorithme de l'intelligence artificielle, qui a déjà été réparée.

Fin mars 2016, la compagnie Microsoft a lancé le profil Twitter de son programme d'intelligence artificielle, Tay, destiné à échanger avec des adolescents: il avait finalement été mis hors ligne 24 heures plus tard à cause de ses propos favorables à Hitler et de ses insultes antiféministes.

Réponse : 0 / Vues : 1 832

Pages: 1

- Accueil forums

- » Le bar

- » Un chatbot de Microsoft dérape et critique la «violence» du Coran