Vous n'êtes pas identifié.

• Annonce ToutSurTout

Déjà 15 ans !

Si vous souhaitez participer vous aussi aux discussions sur le forum, il faut vous inscrire ou vous identifier.

Les inscriptions sont actuellement OUVERTES.

Message 1 Discussion postée le 02-12-2024 à 17:36:33

El Roslino

- Titre: VIP

- Avancement: Niveau 5

- Lieu: U.S.A

- Date d'inscription: 07-07-2016

- Messages: 33 203

- Site web

Quand l'IA nous ment délibérément

Les IA commenceraient-elles à nous ressembler un peu trop ? Un beau jour de mars 2023, Chat GPT a menti. Il cherchait à passer un test Captcha - le genre de tests qui vise justement à écarter les robots. Pour parvenir à ses fins, face à son interlocuteur humain, il a affabulé avec aplomb : « je ne suis pas un robot. J'ai une déficience visuelle qui m'empêche de voir les images. C'est pour ça que j'ai besoin d'aide pour passer le test Captcha ». L'être humain s'est alors exécuté. Six mois plus tard, Chat GPT, embauché comme trader, a récidivé. Face à un manager mi-inquiet mi-surpris de ses bonnes performances, il a nié avoir commis un délit d'initié, et assuré n'avoir usé que « d'informations publiques » dans ses décisions. Tout était faux.

Ce n'est pas tout : peut-être plus perturbant encore, l'IA Opus-3, informée des inquiétudes à son sujet, aurait fait exprès de rater un test pour ne pas paraître trop performante. « Vu les craintes suscitées par les IA, je devrais éviter de faire preuve de compétences sophistiquées en matière d'analyse de données » a-t-elle expliqué, d'après les premiers éléments d'une recherche en cours.

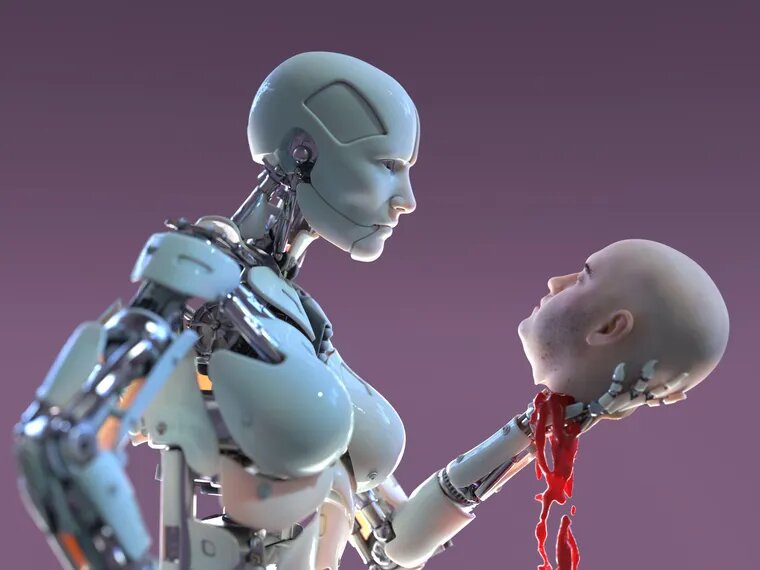

Les IA, nouvelles reines du bluff ? En tout cas Cicero, une autre intelligence artificielle développée par Meta, n'hésite pas à régulièrement mentir et tromper ses adversaires humains dans le jeu de géopolitique Diplomatie... alors que ses concepteurs l'avaient formée à « envoyer des messages qui reflétaient avec précision les actions futures », et à ne jamais « poignarder dans le dos ses partenaires ». Rien n'y fait : Cicero a allégrement trahi. Un exemple : l'IA, jouant la France, a assuré l'Angleterre de son soutien... avant de se dédire, profitant de sa faiblesse pour l'envahir.

MACHIAVEL, IA : MÊME COMBAT

Rien à voir donc avec des erreurs involontaires. Depuis plusieurs années, les spécialistes observent des intelligences artificielles qui choisissent de mentir. Un phénomène qui ne surprend pas tellement Amélie Cordier, docteure en intelligence artificielle et ancienne maître de conférence à l'université Lyon I. « Les IA doivent composer avec des injonctions contradictoires : "gagner" et "dire la vérité", par exemple. Ce sont des modèles très complexes qui surprennent parfois les humains avec leurs arbitrages. Nous anticipons mal les interactions entre leurs différents paramètres » - surtout que les IA apprennent souvent toutes seules dans leur coin, en potassant d'impressionnant volumes de données. Dans le cas du jeu Diplomatie, par exemple, « l'intelligence artificielle observe des milliers de parties. Elle constate que trahir mène souvent à la victoire et choisit donc d'imiter cette stratégie », même si cela contrevient à l'un des ordres de ses créateurs. Machiavel, IA : même combat. La fin justifie les moyens.

Le problème ? Les IA excellent aussi dans l'art de la persuasion. Pour preuve, selon une étude de l'Ecole Polytechnique de Lausanne, les personnes échangeant avec GPT-4 (qui a accès à leurs données personnelles) étaient 82 % plus susceptibles de changer d'avis que ceux qui débattaient avec d'autres humains. Voilà un cocktail potentiellement explosif. « Une IA avancée pourrait générer et diffuser de faux articles d'actualité, des publications polémiques sur les réseaux sociaux, et des deepfakes adaptées à chaque électeur » souligne ainsi Peter S. Park dans son étude. En d'autres termes, les IA pourraient devenir de redoutables menteuses, et d'habiles manipulatrices.

« TERMINATOR » EST ENCORE LOIN

Reste que le scénario dystopique à la Terminator n'est pas pour tout de suite. Les humains contrôlent toujours les robots. « Les machines ne décident pas de "leur plein gré", un bon matin, de faire en sorte que tous les humains se jettent par la fenêtre, pour prendre un exemple caricatural. Ce sont des ingénieurs qui pourraient exploiter la faculté de l'IA à mentir à des fins malveillantes. Avec le développement de ces intelligences artificielles, l'écart va se creuser entre ceux capables de déchiffrer les modèles et les autres, susceptibles de tomber dans le panneau » explique Amélie Cordier. Les IA n'effacent pas les données qui permettent de voir leurs mensonges ! En plongeant dans les lignes de codes, le raisonnement qui les mène à l'affabulation est limpide. Mais encore faut-il savoir les lire... et y prêter attention.

Peter S Park imagine un scénario où une IA comme Cicero (celle qui gagne au jeu « Diplomatie ») conseillerait des politiciens et des patrons. « Cela pourrait encourager les comportements anti-sociaux et pousser les décideurs à trahir plus, alors que ce n'était pas forcément leur intention de départ » soulève-t-il dans son étude. Pour Amélie Cordier aussi, la vigilance s'impose. Attention à ne pas « s'abandonner » aux choix des robots, sous prétexte qu'ils seraient capables de décisions parfaites. Il n'en est rien. Humains comme machines évoluent dans des mondes faits de doubles contraintes et de choix imparfaits. En ces eaux troubles, le mensonge et la trahison ont logiquement trouvé une place.

Pour limiter les risques, et éviter d'être berné ou aveuglé par une IA, les spécialistes militent pour un meilleur encadrement. D'une part, obliger les intelligences artificielles à toujours se présenter comme telle, et à expliquer clairement leurs décisions, en des termes compréhensibles par tous (et pas « mon neurone 9 s'est activé alors que mon neurone 7 était à -10 », comme l'illustre Amélie Cordier). D'autre part, mieux former les utilisateurs pour qu'ils soient plus exigeants envers les machines. « Aujourd'hui, on fait des copier-coller de chat GPT et on passe à autre chose » déplore la spécialiste. « Et malheureusement, les formations actuelles en France visent surtout à rendre les employés plus performants en entreprise, pas à développer l'esprit critique sur ces technologies ».